Искусственный интеллект, нейросети

179,351

1,045

|

|

Slav Rus ( Слушатель ) |

| 24 фев 2023 13:46:06 |

Многозадачная модель T5 для русского языка

новая дискуссия Дискуссия 202

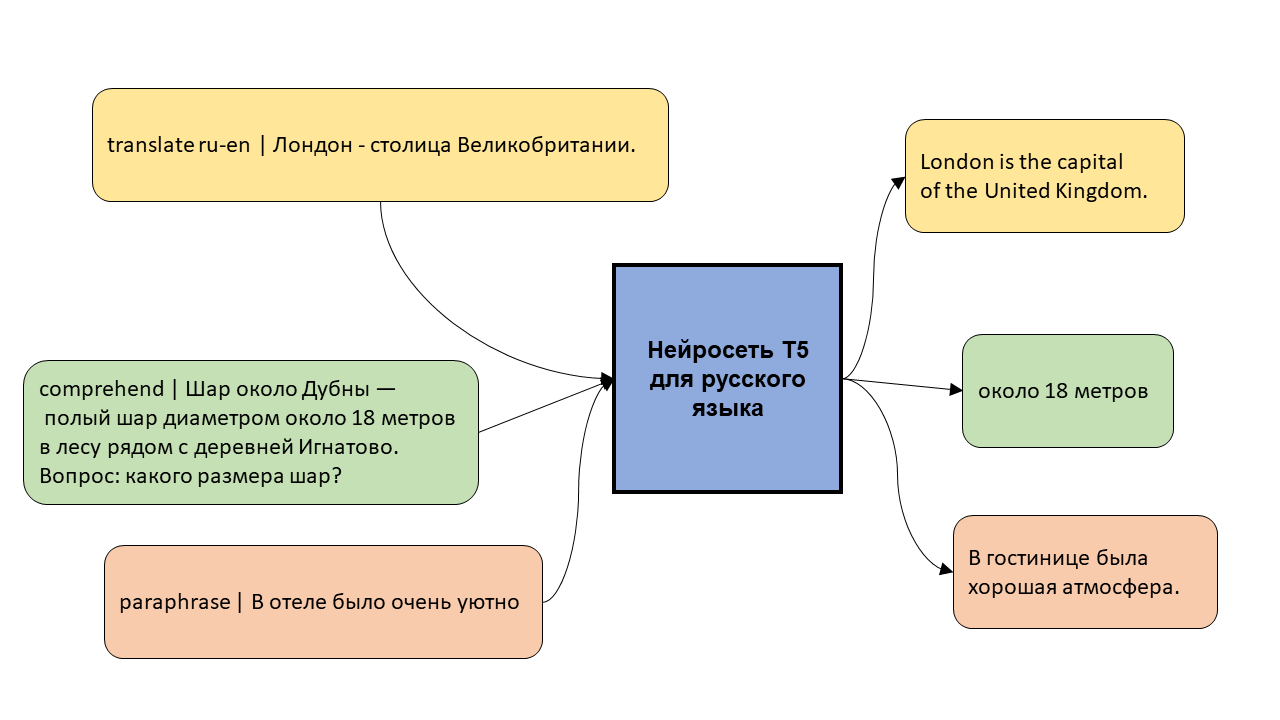

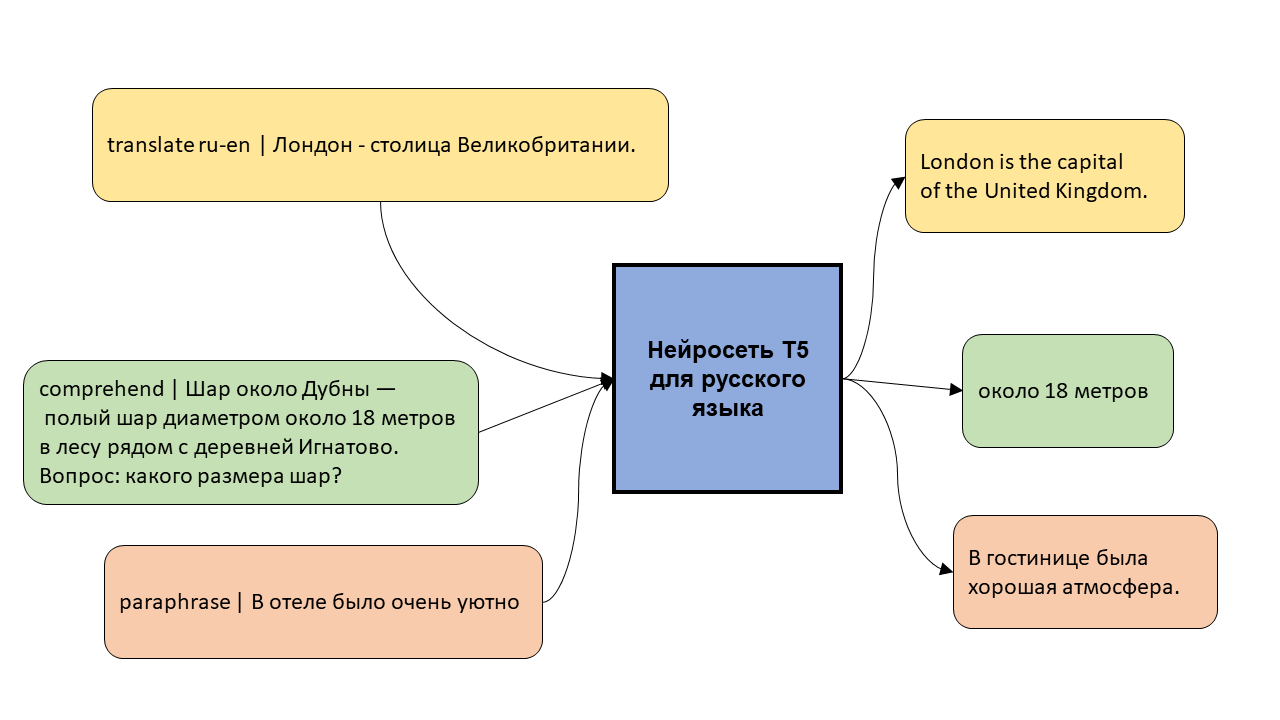

Модель T5 – это нейросеть, которая уже обучена хорошо понимать и генерировать текст, и которую можно дообучить на собственную задачу, будь то перевод, суммаризация текстов, или генерация ответа чат-бота.

В этом посте я рассказываю про первую многозадачную модель T5 для русского языка и показываю, как её можно обучить на новой задаче.

Русскоязычная модель T5 худо-бедно решает десяток разных задач

.

Зачем нужна русскоязычная T5

T5 – нейросетевая модель для понимания и генерации текста. Изобрели её в работе от Google два года назад, и расшифровывается это название как text-to-text transfer transformer. Трансформер – это архитектура нейросетей, позволяющая извлекать из текста довольно объёмную информацию. Благодаря этой архитектуре модели типа BERT круто понимают тексты, а модели типа GPT весьма правдоподобно их генерируют. Text-to-text означает, что модель T5 принимает на вход тексты и "читает" их энкодером (как BERT), а потом "пишет" декодером новые тексты и отдаёт на выход. Слово transfer говорит о цели этой модели: она предобучалась восстанавливать пропущенные фрагменты текста, но при желании её можно дообучить на новые, более полезные задачи: перевод, перефразирование, суммаризация текстов, генерация диалоговых ответов, и т.п.

Гугл выпустил две версии T5: первая понимает только английский язык, зато дообучалась на 24 разных задачах, а вторая понимает 101 язык (включая русский), но умеет только заполнять пропуски в тексте. Поэтому я решил сначала ужать мультиязычную модель T5 (mT5) до двух языков: русского и английского, выкинув ненужные токены из её словаря и соответствующие строки из матриц входных и выходных эмбеддингов. Процесс подробно описан в этом посте, а в результате модель "похудела" с 2.2 до 0.9 ГБ, а значит, стала более удобной для применения. Эту уменьшенная модель я выложил под именем cointegrated/rut5-base. А дальше я пошёл по пути Google и дообучил свою русскую T5 решать одновременно несколько разных русских и англоязычных задач.

Многозадачная модель

....

https://habr.com/ru/post/581932/

В этом посте я рассказываю про первую многозадачную модель T5 для русского языка и показываю, как её можно обучить на новой задаче.

Русскоязычная модель T5 худо-бедно решает десяток разных задач

.

Зачем нужна русскоязычная T5

T5 – нейросетевая модель для понимания и генерации текста. Изобрели её в работе от Google два года назад, и расшифровывается это название как text-to-text transfer transformer. Трансформер – это архитектура нейросетей, позволяющая извлекать из текста довольно объёмную информацию. Благодаря этой архитектуре модели типа BERT круто понимают тексты, а модели типа GPT весьма правдоподобно их генерируют. Text-to-text означает, что модель T5 принимает на вход тексты и "читает" их энкодером (как BERT), а потом "пишет" декодером новые тексты и отдаёт на выход. Слово transfer говорит о цели этой модели: она предобучалась восстанавливать пропущенные фрагменты текста, но при желании её можно дообучить на новые, более полезные задачи: перевод, перефразирование, суммаризация текстов, генерация диалоговых ответов, и т.п.

Гугл выпустил две версии T5: первая понимает только английский язык, зато дообучалась на 24 разных задачах, а вторая понимает 101 язык (включая русский), но умеет только заполнять пропуски в тексте. Поэтому я решил сначала ужать мультиязычную модель T5 (mT5) до двух языков: русского и английского, выкинув ненужные токены из её словаря и соответствующие строки из матриц входных и выходных эмбеддингов. Процесс подробно описан в этом посте, а в результате модель "похудела" с 2.2 до 0.9 ГБ, а значит, стала более удобной для применения. Эту уменьшенная модель я выложил под именем cointegrated/rut5-base. А дальше я пошёл по пути Google и дообучил свою русскую T5 решать одновременно несколько разных русских и англоязычных задач.

Многозадачная модель

....

https://habr.com/ru/post/581932/

ОТВЕТЫ (1)

|

|

Поверонов ( Слушатель ) |

| 24 фев 2023 20:20:53 |

Цитата: Slav Rus от 24.02.2023 13:46:06

Посмотрим, насколько хорошо модель выучила свою тренировочную выборку.

Какое животное раньше называли камелопардом?

answer: Жираф

model: акула

---

Грамматическая категория глагола, выражающая отношение действия к действительности (в лингвистике)

answer: наклонение

model: действие

---

О чём поется в песне Greenday – «Wake Me Up When September Ends» (Разбуди меня, когда сентябрь кончится)?

answer: О смерти его отца

model: о лете

---

Соседка Земли по Солнечной системе

answer: Венера

model: Африка

---

Отношение размеров на чертеже, карте и т. п. к действительным размерам на местности, предмете

answer: масштаб

model: пропорциональность

модель пытается, но часто "мажет". Возможно, стоит поучить её в течение ещё нескольких эпох.

А теперь посмотрим, насколько хорошо модель справляется с ответами на вопросы, которые она не видела.

Минерал, сульфид марганца

answer: алабандин

model: сульфид

---

Где находится родина табака?

answer: Южная Америка

model: Бразилия

---

Старинный русский головной убор с приподнятым вверх спереди и сзади околышем

answer: кораблик

model: шнур

---

Почетное звание у тюрков и монголов, дававшееся за воинские подвиги

answer: батыр

model: аким

---

Счетный прибор

answer: арифмометр

model: таблица

PS Эллочку модель явно превосходит. Но не слишком