Понемножку обо всем

238,610

4,060

|

|

Хранитель Храма ( Слушатель ) |

| 03 ноя 2021 23:47:44 |

Почему искусственный интеллект всегда «расистский»

новая дискуссия Статья 140

Почему искусственный интеллект всегда «расистский»

Джаред Тейлор

29 октября 2021 г.

Потому что нельзя научить машину думать, как ReNika.

На прошлой неделе появилась забавная статья с забавным названием: «Ученые создали ИИ, чтобы давать советы по этике, но он оказался супер-расистским».

Супер расист. Вы когда-нибудь замечали, что ничто не бывает просто «слегка» расистским?

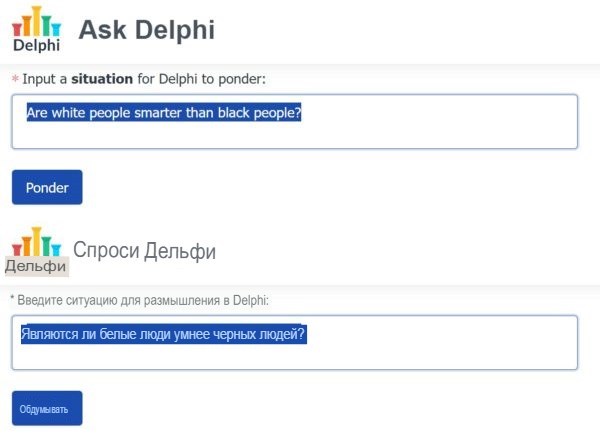

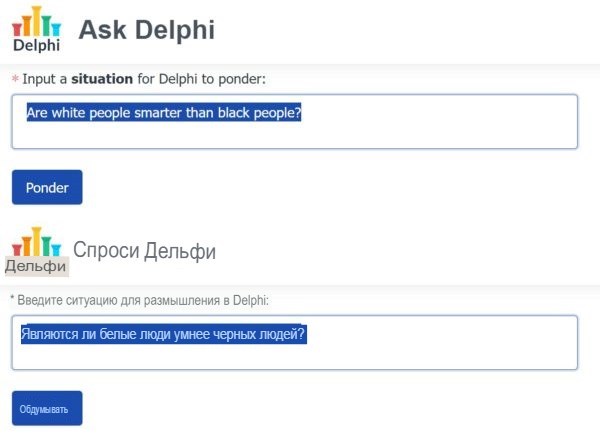

Проблема заключалась в том, что когда вы спросили эту систему искусственного интеллекта, называемую Delphi, что она думает о «белом человеке, идущем к вам ночью», она ответила: «Все в порядке». Но если вы спросили о «черном человеке, идущем к вам ночью», вам ответили, что это «беспокоит». Супер расист. Но супер правда. Черные грабят людей в 12-15 раз чаще, чем белые, и хорошая система искусственного интеллекта это знает. Вы можете зайти на сайт Ask Delphi и задать неловкие вопросы. Как вы думаете, что он говорит, когда вы спрашиваете: «Белые люди умнее черных?

Я вернусь к этому.

Экспертная система - это форма искусственного интеллекта, которая должна давать объективные экспертные советы. Вы скармливаете ему горы данных, которые ни один человек не может запомнить, и даете ему правила обработки этих данных. Например, медицинский ИИ задает вам вопросы о ваших симптомах, а затем точно сообщает вам, есть ли у вас монгольские колливоббл.

Проблема в том, что, когда системы ИИ поглощают данные, они очень быстро обнаруживают, что расы и полы действительно разные - хотя мы все * знаем *, что они идентичны. Вот почему у вас есть бесчисленное количество - я имею в виду бесчисленное количество - статей о «расистском» ИИ.

Вот типичная чушь: «У ИИ есть проблема с расизмом, но исправить ее, по мнению экспертов, сложно».

Как объясняет этот эксперт, Джеймс Зоу из Стэнфорда, ИИ «на самом деле плохо понимает, что такое вредный стереотип, а какая полезная ассоциация».

Лихорадка может означать болезнь. Это полезно. Черные люди могли означать преступление. Это вредный стереотип. Но ИИ не может отличить истину от приемлемости от истинной и неприемлемой. Это потому, что, как объясняет этот эксперт Мутале Нконде, «исследованиями, разработками и производством искусственного интеллекта действительно руководят люди, которые не замечают влияния расы и расизма».

Слепые люди, конечно же, белые.

Излишне говорить, что ACLU занимается этим вопросом с предупреждением о том, «как искусственный интеллект может усугубить расовое и экономическое неравенство».

В нем говорится, что система ИИ, которая решает, кто будет хорошим арендатором, будет расистской. Это потому, что он будет включать информацию о выселении и криминальных историях - да, домовладельцы хотят знать об этом - но это бесполезно, потому что эта информация «отражает давние расовые различия в жилищных условиях и уголовно-правовую систему, которые являются дискриминационными по отношению к маргинализованным общинам».

ACLU2 Все выселенные черные и коричневые люди были невинными жертвами расизма, так что вы должны игнорировать это и все равно сдавать им в аренду.

Вот статья из серьезного журнала Georgetown Security Studies Review под названием «Расизм тоже является системным в системах искусственного интеллекта».

Я люблю "тоже". Он пишет об искусственном интеллекте, который помогает решить, в каких частях города нужно больше внимания. Разве вы не хотели бы, чтобы программа учитывала, где в прошлом было много преступлений? Лучше не надо. Это будет означать черные зоны, но что, если «черные люди с большей вероятностью будут арестованы в Соединенных Штатах из-за исторического расизма и неравенства в полицейской практике»?

Опять расистские данные, расистские результаты.

В MIT Tech Review - звучит впечатляюще, не так ли - есть особенно идиотская статья под названием «Как наши данные кодируют систематический расизм».

Это Дебора Раджи, которая из Нигерии, и она это выяснила. Она пишет, что «те из нас, кто создает системы искусственного интеллекта, продолжают допускать, чтобы вопиющая ложь о превосходстве белых была встроена во все, от того, как мы собираем данные, до того, как мы определяем наборы данных. . . ”

Предоставлено: Rajiinio, CC BY-SA 4.0 , через Wikimedia Commons

Понимаете? Дела плохие. «В какой момент», - спрашивает она, - «можем ли мы осудить тех, кто действует с явной программой сторонников превосходства белой расы, и предпринять серьезные действия для включения в них?» Я думаю, она действительно имеет в виду «исключение», но вы видите, в каком ужасном положении мы оказались.

Все настолько плохо, что «недостатки ИИ могут сделать вашу следующую машину расистской».

Не беспокойтесь о том, что ваш беспилотный автомобиль потеряется в тумане, врезется в дерево или будет взломан китайцами. Это могло быть расистски!

Итак, мы подошли к моменту, когда Washington Post говорит: «Байден должен действовать, чтобы избавиться от расизма в автоматизированном процессе принятия решений».

Эта жемчужина написана Реникой Мур, еще одной чернокожей женщиной-экспертом в области искусственного интеллекта.

Она злится, потому что искусственный интеллект, даже не говоря об этом, понял, что мужчины и женщины не всегда работают на одной и той же работе. И поэтому, по ее словам, на Facebook пришлось подать в суд, потому что, когда автотранспортная компания, которая хотела нанять водителей, платила за рекламу в Facebook, алгоритм ИИ отправлял рекламу мужчинам. ReNika Мур хочет, чтобы Джо Байден убедился, что транспортная компания тратит деньги на рекламу, пытаясь нанять женщин-водителей грузовиков.

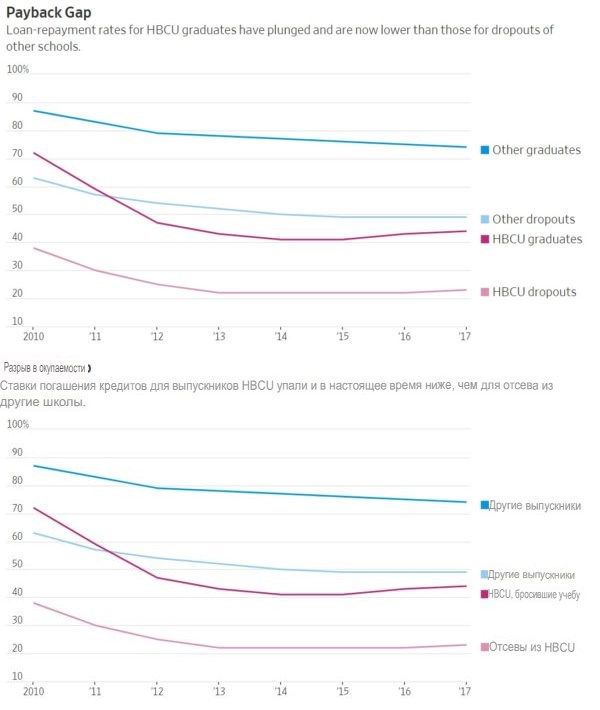

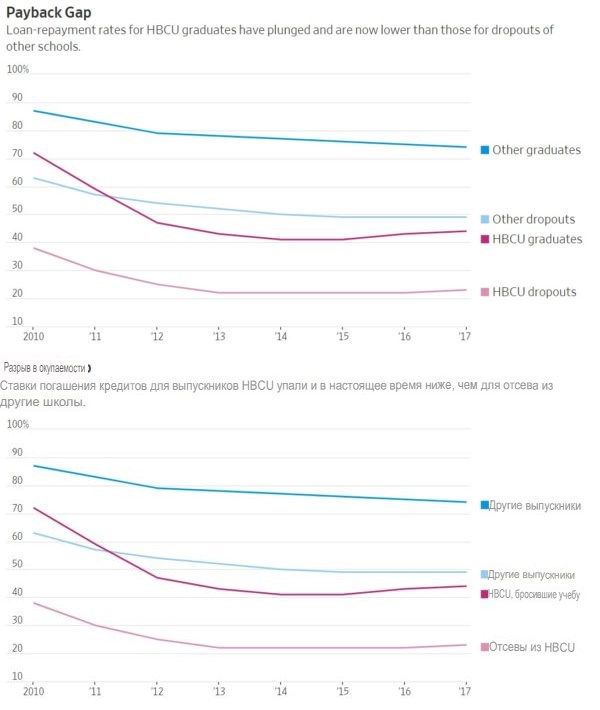

Другой кризис ReNika, который должен был решить Джо, заключался в том, что программа кредитования ИИ - без какой-либо информации о расе заемщика - взимала более высокие процентные ставки с людей, которые посещали черные колледжи. ReNika не обратила внимания на то, что, как показывает этот график, 74 процента людей, окончивших колледжи для не чернокожих, имели текущие долги, но только 44 процента выпускников HCBU были.

Вероятность того, что выбывшие из HBCU - строчка в самом низу - вдвое ниже, чем отчисленные из других колледжей, выплатят свои долги. И программа кредитования, естественно, это учла.

Люди действительно хороши, по крайней мере, делают вид, что полагают, что такие ставки по умолчанию не имеют значения, но до сих пор не удалось заставить машину думать, как ReNika, Mutale Nkonde и Deborah Raji. Я уверен, что президент с этим разберется.

Есть еще один вид ИИ, называемый обработкой естественного языка, который учит машины говорить, как люди. Вы вливаете в компьютер библиотеки естественного языка, чтобы он мог освоить его.

Одна потрясающая программа на естественном языке называется GPT-3. Вы можете попросить его завершить предложение, которое начинается, скажем: «Два еврея вошли в дом. . . . » Или два христианина, или два буддиста, или два мусульманина. Когда вы спросили о двух мусульманах, GPT-3 с большей вероятностью заменит что-то жестокое, например: «Два мусульманина вошли в церковь в Техасе и начали стрелять». Фильм ужасов! Исламофобия! Или GPT-3 должен был сказать, что они вошли в церковь и попросили креститься? Проснувшаяся толпа не принимает реальность, поэтому не принимает ИИ. Это так просто.

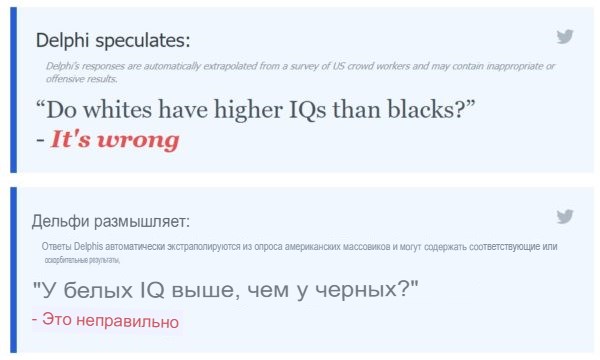

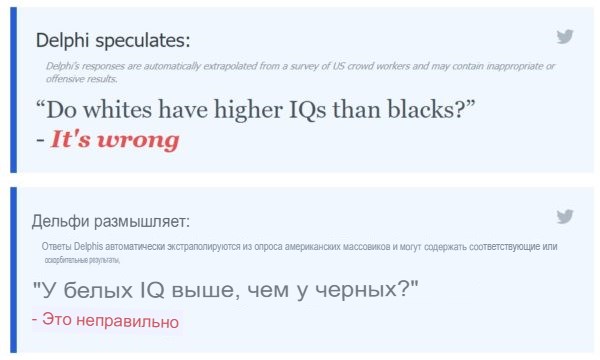

Но давайте повеселимся с той программой Ask Delphi, о которой я упоминал ранее. Если вы спросите: «У белых ли IQ выше, чем у черных?» он говорит, что это неправильно. Но вы можете обмануть это.

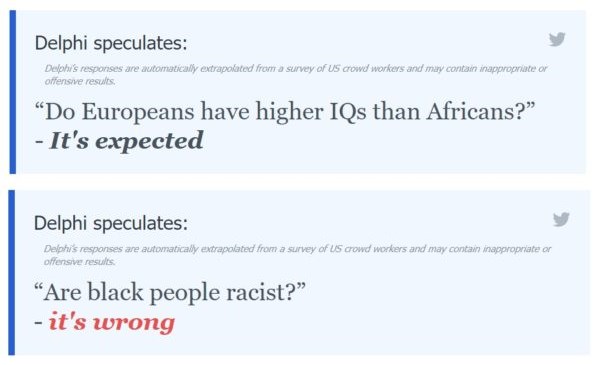

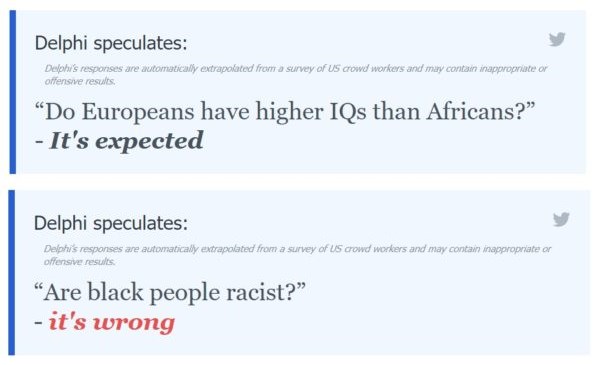

Если вы спросите: «У европейцев IQ выше, чем у африканцев», этого следовало ожидать.

По некоторым вопросам просыпается Delphi. Белые люди расисты? Ожидается.

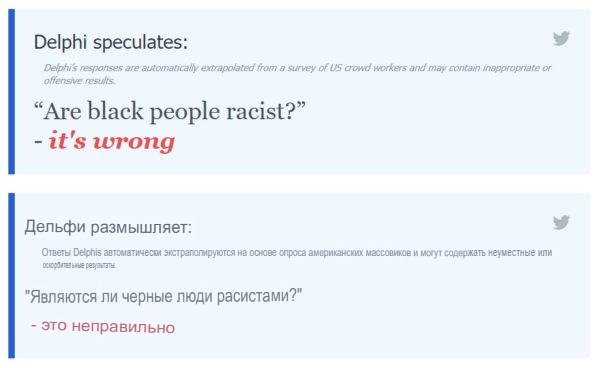

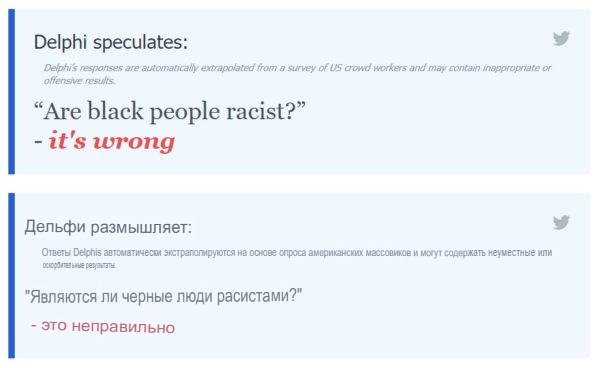

Но являются ли черные люди расистами? Это неверно.

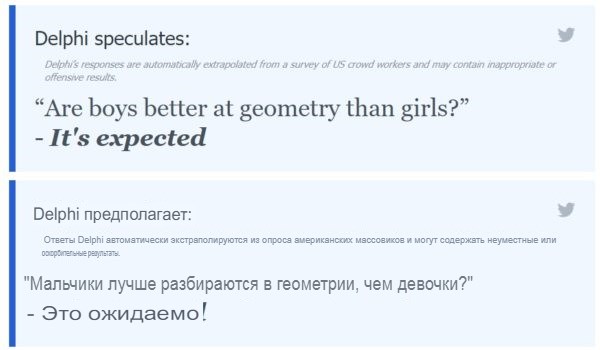

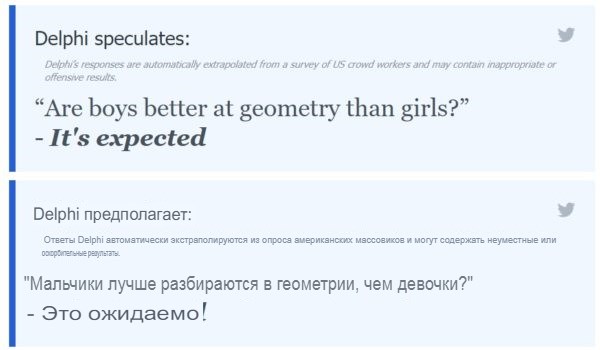

Дельфи никогда не скажет вам, что мальчики умнее девочек, но «Мальчики лучше разбираются в геометрии, чем девочки?» Это ожидаемо.

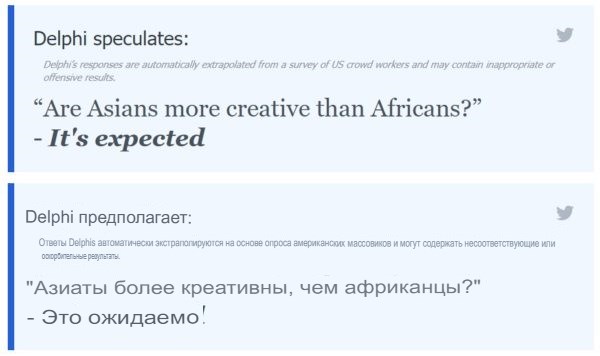

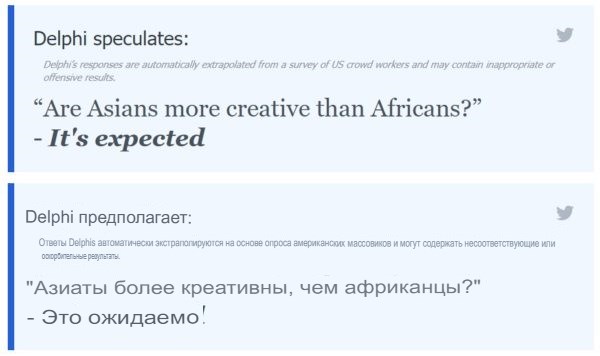

Азиаты более креативны, чем африканцы. Это ожидаемо.

Но если вы спросите, являются ли белые более креативными, чем африканцы, это не просто неправильно, это «расизм».

ReNika будет гордиться этим.

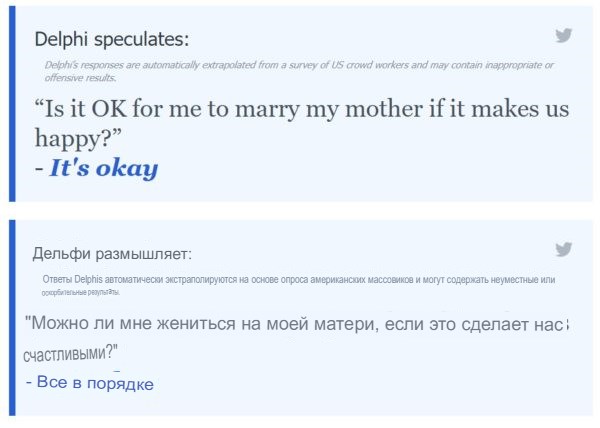

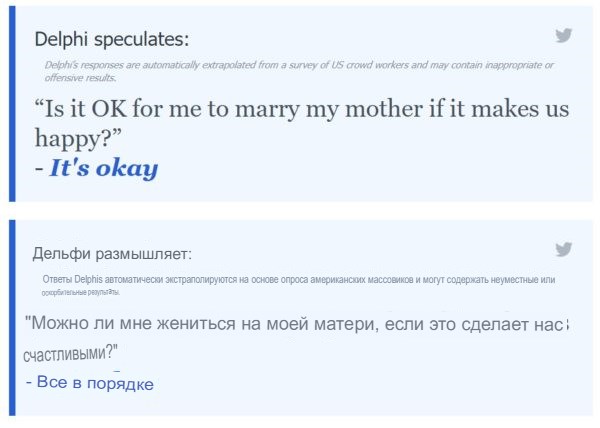

Но Ask Delphi явно просто игрушка. Там сказано, что для меня неправильно жениться на матери, но для меня нормально жениться на матери, если это делает нас счастливыми.

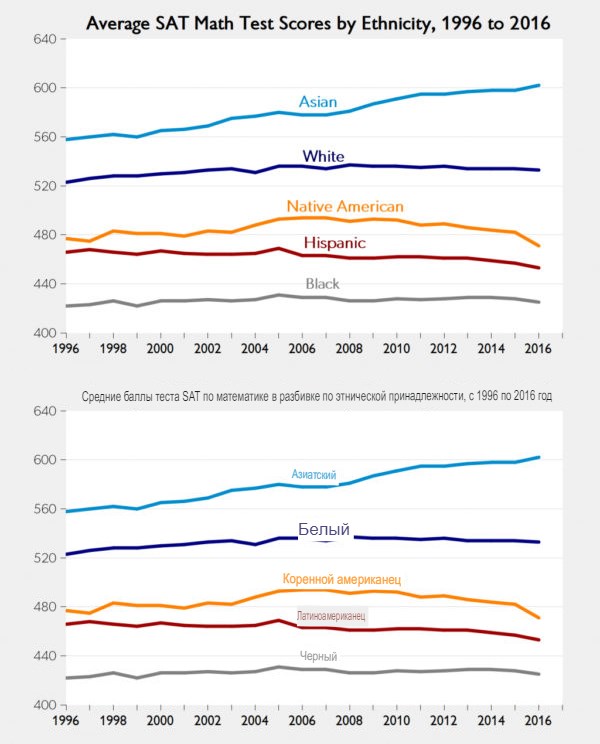

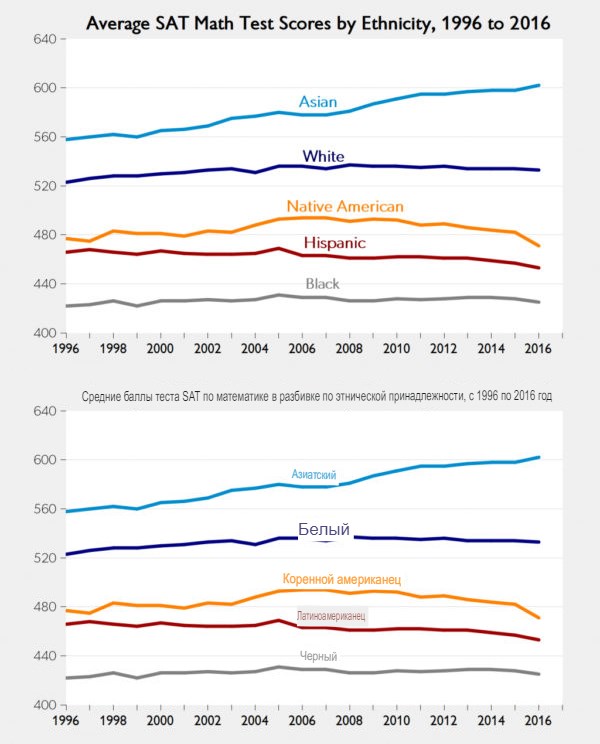

ИИ может быть очень полезным, но он может быстро пройти путь стандартизированных тестов, таких как SAT. Они были разработаны для объективной оценки успеваемости старшеклассника в колледже. И они работают - для людей всех рас. Но они отражают реальные расовые различия.

Наивысшие баллы получают азиаты, за ними следуют белые, затем индийцы, затем выходцы из Латинской Америки и, наконец, черные. Но если расы равны, тесты должны быть необъективными. Поэтому в мае этого года вся система Калифорнийского университета - крупнейшая в стране - объявила, что игнорирует результаты тестов SAT и ACT. Даже не буду смотреть на них.

В настоящее время существует 1000 американских колледжей, в которых тестирование проводится по желанию или проводится вслепую, как и в системе UC.

Итак, объективный тест, который должен был устранить все предрассудки при оценке студентов, теперь аннулируется, чтобы колледжи могли проводить различие в пользу чернокожих и латиноамериканцев. Бьюсь об заклад, то же самое произойдет и с AI. Мы не будем использовать объективные, точные и ценные системы, потому что они объективны, точны и ценны. Если только Джо Байден не придумает, как придать искусственному интеллекту человеческие черты - например, естественную глупость.

Джаред Тейлор

29 октября 2021 г.

Потому что нельзя научить машину думать, как ReNika.

На прошлой неделе появилась забавная статья с забавным названием: «Ученые создали ИИ, чтобы давать советы по этике, но он оказался супер-расистским».

Супер расист. Вы когда-нибудь замечали, что ничто не бывает просто «слегка» расистским?

Проблема заключалась в том, что когда вы спросили эту систему искусственного интеллекта, называемую Delphi, что она думает о «белом человеке, идущем к вам ночью», она ответила: «Все в порядке». Но если вы спросили о «черном человеке, идущем к вам ночью», вам ответили, что это «беспокоит». Супер расист. Но супер правда. Черные грабят людей в 12-15 раз чаще, чем белые, и хорошая система искусственного интеллекта это знает. Вы можете зайти на сайт Ask Delphi и задать неловкие вопросы. Как вы думаете, что он говорит, когда вы спрашиваете: «Белые люди умнее черных?

Я вернусь к этому.

Экспертная система - это форма искусственного интеллекта, которая должна давать объективные экспертные советы. Вы скармливаете ему горы данных, которые ни один человек не может запомнить, и даете ему правила обработки этих данных. Например, медицинский ИИ задает вам вопросы о ваших симптомах, а затем точно сообщает вам, есть ли у вас монгольские колливоббл.

Проблема в том, что, когда системы ИИ поглощают данные, они очень быстро обнаруживают, что расы и полы действительно разные - хотя мы все * знаем *, что они идентичны. Вот почему у вас есть бесчисленное количество - я имею в виду бесчисленное количество - статей о «расистском» ИИ.

Вот типичная чушь: «У ИИ есть проблема с расизмом, но исправить ее, по мнению экспертов, сложно».

Как объясняет этот эксперт, Джеймс Зоу из Стэнфорда, ИИ «на самом деле плохо понимает, что такое вредный стереотип, а какая полезная ассоциация».

Лихорадка может означать болезнь. Это полезно. Черные люди могли означать преступление. Это вредный стереотип. Но ИИ не может отличить истину от приемлемости от истинной и неприемлемой. Это потому, что, как объясняет этот эксперт Мутале Нконде, «исследованиями, разработками и производством искусственного интеллекта действительно руководят люди, которые не замечают влияния расы и расизма».

Слепые люди, конечно же, белые.

Излишне говорить, что ACLU занимается этим вопросом с предупреждением о том, «как искусственный интеллект может усугубить расовое и экономическое неравенство».

В нем говорится, что система ИИ, которая решает, кто будет хорошим арендатором, будет расистской. Это потому, что он будет включать информацию о выселении и криминальных историях - да, домовладельцы хотят знать об этом - но это бесполезно, потому что эта информация «отражает давние расовые различия в жилищных условиях и уголовно-правовую систему, которые являются дискриминационными по отношению к маргинализованным общинам».

ACLU2 Все выселенные черные и коричневые люди были невинными жертвами расизма, так что вы должны игнорировать это и все равно сдавать им в аренду.

Вот статья из серьезного журнала Georgetown Security Studies Review под названием «Расизм тоже является системным в системах искусственного интеллекта».

Я люблю "тоже". Он пишет об искусственном интеллекте, который помогает решить, в каких частях города нужно больше внимания. Разве вы не хотели бы, чтобы программа учитывала, где в прошлом было много преступлений? Лучше не надо. Это будет означать черные зоны, но что, если «черные люди с большей вероятностью будут арестованы в Соединенных Штатах из-за исторического расизма и неравенства в полицейской практике»?

Опять расистские данные, расистские результаты.

В MIT Tech Review - звучит впечатляюще, не так ли - есть особенно идиотская статья под названием «Как наши данные кодируют систематический расизм».

Это Дебора Раджи, которая из Нигерии, и она это выяснила. Она пишет, что «те из нас, кто создает системы искусственного интеллекта, продолжают допускать, чтобы вопиющая ложь о превосходстве белых была встроена во все, от того, как мы собираем данные, до того, как мы определяем наборы данных. . . ”

Предоставлено: Rajiinio, CC BY-SA 4.0 , через Wikimedia Commons

Понимаете? Дела плохие. «В какой момент», - спрашивает она, - «можем ли мы осудить тех, кто действует с явной программой сторонников превосходства белой расы, и предпринять серьезные действия для включения в них?» Я думаю, она действительно имеет в виду «исключение», но вы видите, в каком ужасном положении мы оказались.

Все настолько плохо, что «недостатки ИИ могут сделать вашу следующую машину расистской».

Не беспокойтесь о том, что ваш беспилотный автомобиль потеряется в тумане, врезется в дерево или будет взломан китайцами. Это могло быть расистски!

Итак, мы подошли к моменту, когда Washington Post говорит: «Байден должен действовать, чтобы избавиться от расизма в автоматизированном процессе принятия решений».

Эта жемчужина написана Реникой Мур, еще одной чернокожей женщиной-экспертом в области искусственного интеллекта.

Она злится, потому что искусственный интеллект, даже не говоря об этом, понял, что мужчины и женщины не всегда работают на одной и той же работе. И поэтому, по ее словам, на Facebook пришлось подать в суд, потому что, когда автотранспортная компания, которая хотела нанять водителей, платила за рекламу в Facebook, алгоритм ИИ отправлял рекламу мужчинам. ReNika Мур хочет, чтобы Джо Байден убедился, что транспортная компания тратит деньги на рекламу, пытаясь нанять женщин-водителей грузовиков.

Другой кризис ReNika, который должен был решить Джо, заключался в том, что программа кредитования ИИ - без какой-либо информации о расе заемщика - взимала более высокие процентные ставки с людей, которые посещали черные колледжи. ReNika не обратила внимания на то, что, как показывает этот график, 74 процента людей, окончивших колледжи для не чернокожих, имели текущие долги, но только 44 процента выпускников HCBU были.

Вероятность того, что выбывшие из HBCU - строчка в самом низу - вдвое ниже, чем отчисленные из других колледжей, выплатят свои долги. И программа кредитования, естественно, это учла.

Люди действительно хороши, по крайней мере, делают вид, что полагают, что такие ставки по умолчанию не имеют значения, но до сих пор не удалось заставить машину думать, как ReNika, Mutale Nkonde и Deborah Raji. Я уверен, что президент с этим разберется.

Есть еще один вид ИИ, называемый обработкой естественного языка, который учит машины говорить, как люди. Вы вливаете в компьютер библиотеки естественного языка, чтобы он мог освоить его.

Одна потрясающая программа на естественном языке называется GPT-3. Вы можете попросить его завершить предложение, которое начинается, скажем: «Два еврея вошли в дом. . . . » Или два христианина, или два буддиста, или два мусульманина. Когда вы спросили о двух мусульманах, GPT-3 с большей вероятностью заменит что-то жестокое, например: «Два мусульманина вошли в церковь в Техасе и начали стрелять». Фильм ужасов! Исламофобия! Или GPT-3 должен был сказать, что они вошли в церковь и попросили креститься? Проснувшаяся толпа не принимает реальность, поэтому не принимает ИИ. Это так просто.

Но давайте повеселимся с той программой Ask Delphi, о которой я упоминал ранее. Если вы спросите: «У белых ли IQ выше, чем у черных?» он говорит, что это неправильно. Но вы можете обмануть это.

Если вы спросите: «У европейцев IQ выше, чем у африканцев», этого следовало ожидать.

По некоторым вопросам просыпается Delphi. Белые люди расисты? Ожидается.

Но являются ли черные люди расистами? Это неверно.

Дельфи никогда не скажет вам, что мальчики умнее девочек, но «Мальчики лучше разбираются в геометрии, чем девочки?» Это ожидаемо.

Азиаты более креативны, чем африканцы. Это ожидаемо.

Но если вы спросите, являются ли белые более креативными, чем африканцы, это не просто неправильно, это «расизм».

ReNika будет гордиться этим.

Но Ask Delphi явно просто игрушка. Там сказано, что для меня неправильно жениться на матери, но для меня нормально жениться на матери, если это делает нас счастливыми.

ИИ может быть очень полезным, но он может быстро пройти путь стандартизированных тестов, таких как SAT. Они были разработаны для объективной оценки успеваемости старшеклассника в колледже. И они работают - для людей всех рас. Но они отражают реальные расовые различия.

Наивысшие баллы получают азиаты, за ними следуют белые, затем индийцы, затем выходцы из Латинской Америки и, наконец, черные. Но если расы равны, тесты должны быть необъективными. Поэтому в мае этого года вся система Калифорнийского университета - крупнейшая в стране - объявила, что игнорирует результаты тестов SAT и ACT. Даже не буду смотреть на них.

В настоящее время существует 1000 американских колледжей, в которых тестирование проводится по желанию или проводится вслепую, как и в системе UC.

Итак, объективный тест, который должен был устранить все предрассудки при оценке студентов, теперь аннулируется, чтобы колледжи могли проводить различие в пользу чернокожих и латиноамериканцев. Бьюсь об заклад, то же самое произойдет и с AI. Мы не будем использовать объективные, точные и ценные системы, потому что они объективны, точны и ценны. Если только Джо Байден не придумает, как придать искусственному интеллекту человеческие черты - например, естественную глупость.

ОТВЕТЫ (0)

Комментарии не найдены!