Понемножку обо всем

238,064

4,060

|

|

Хранитель Храма ( Слушатель ) |

| 26 июн 2022 12:15:17 |

Искусственный интеллект Google - это нечто еще более странное, чем сознательный

новая дискуссия Статья 195

Искусственный интеллект Google - это нечто еще более странное, чем сознательный

Машинное восприятие переоценено.

By Stephen Marche

19 ИЮНЯ 2022 ГОДА

Беттманн / Гетти

На прошлой неделе Google отправил одного из своих инженеров в административный отпуск после того, как он заявил, что столкнулся с машинным разумом в диалоге с агентом по имени ЛаМДА. Поскольку машинный разум является основным элементом фильмов, а мечта об искусственной личности стара, как сама наука, история стала вирусной, привлекая гораздо больше внимания, чем почти любая история об обработке естественного языка (NLP), которую когда-либо получали. Это позор. Представление о том, что LaMDA обладает разумом, является бессмыслицей: LaMDA не более сознателен, чем карманный калькулятор. Что еще более важно, глупой фантазии о машинном разуме снова позволили доминировать в разговорах об искусственном интеллекте, когда происходят гораздо более странные и богатые, потенциально опасные и красивые разработки.

Тот факт, что LaMDA, в частности, была в центре внимания, откровенно говоря, немного странный. ЛаМДА - диалоговый агент. Цель диалоговых агентов - убедить вас в том, что вы разговариваете с человеком. На данный момент совершенно убедительные чат-боты далеки от новаторских технологий. Такие программы, как Project December, уже способны воссоздавать умерших близких с помощью НЛП. Но эти симуляции не более живые, чем фотография вашего покойного прадеда.

Уже существуют модели, более мощные и загадочные, чем LaMDA. LaMDA оперирует до 137 миллиардами параметров, которые, говоря в широком смысле, представляют собой языковые шаблоны, которые НЛП на основе трансформатора использует для создания осмысленного текстового прогнозирования. Недавно я разговаривал с инженерами, работавшими над последней языковой моделью Google PaLM, которая имеет 540 миллиардов параметров и способна выполнять сотни отдельных задач без специального обучения для их выполнения. Это настоящий искусственный интеллект общего назначения, поскольку он может применяться к различным интеллектуальным задачам без специальной подготовки, так сказать, “из коробки”.

Некоторые из этих задач, очевидно, полезны и потенциально преобразуют. По словам инженеров — и, чтобы быть ясным, я сам не видел PaLM в действии, потому что это не продукт — если вы задаете ему вопрос на бенгальском, он может ответить как на бенгальском, так и на английском. Если вы попросите его перевести фрагмент кода с C на Python, он может это сделать. Он может обобщать текст. Он может объяснить шутки. Кроме того, есть функция, которая поразила ее собственных разработчиков и которая требует определенной дистанции и интеллектуальной хладнокровности, чтобы не волноваться. PaLM может рассуждать. Или, если быть более точным — и точность здесь очень важна — PaLM может действовать разумно.

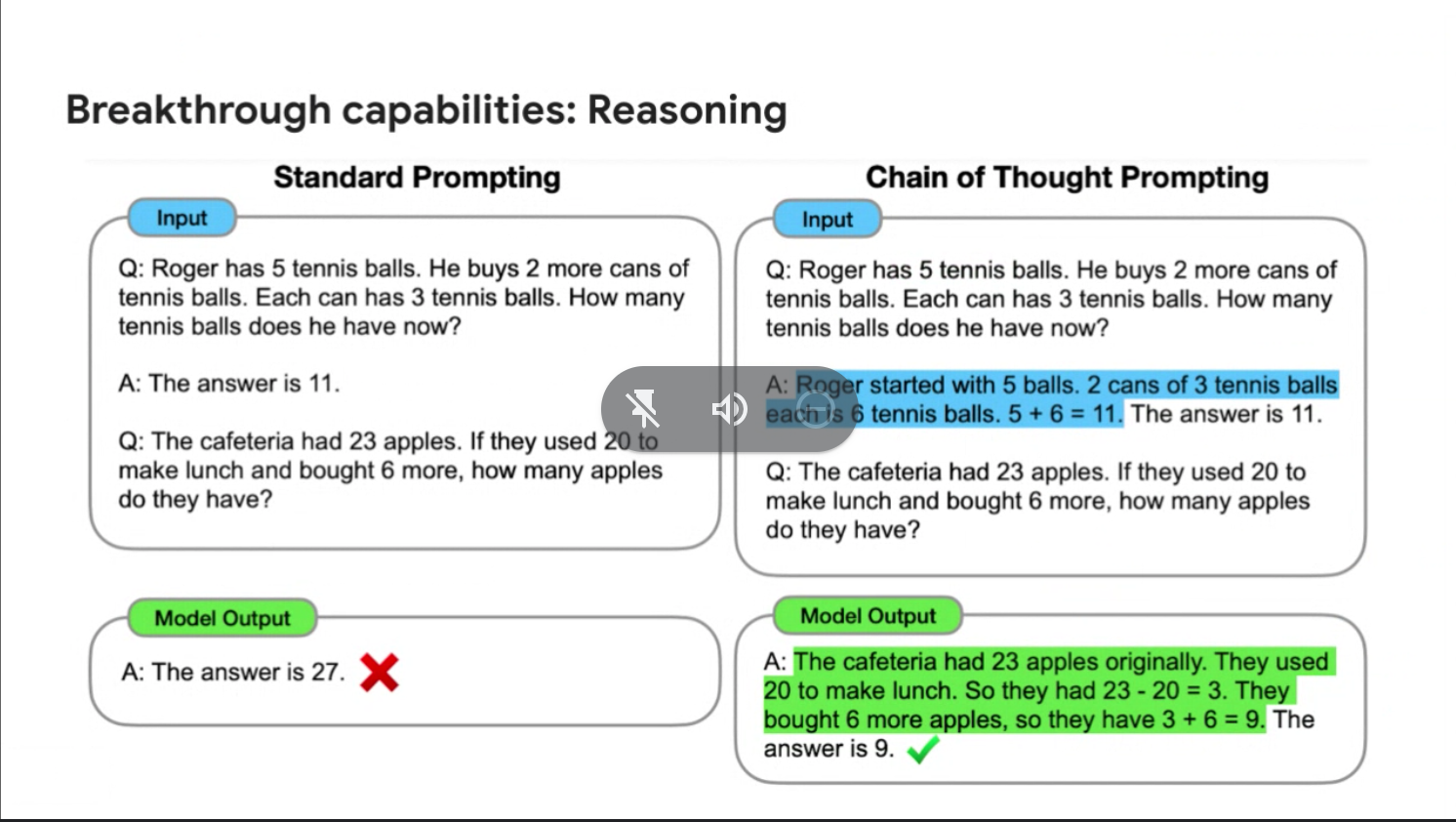

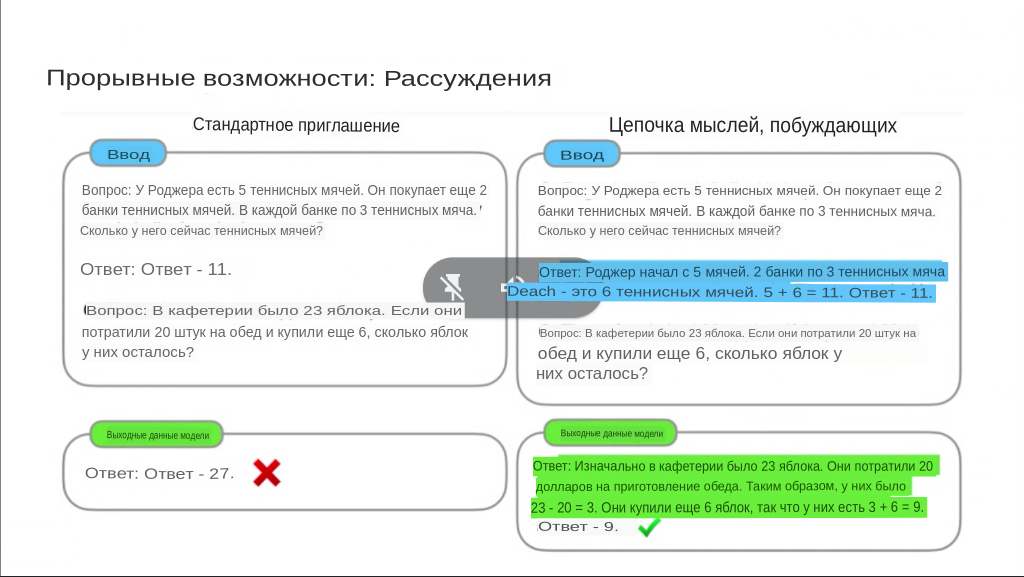

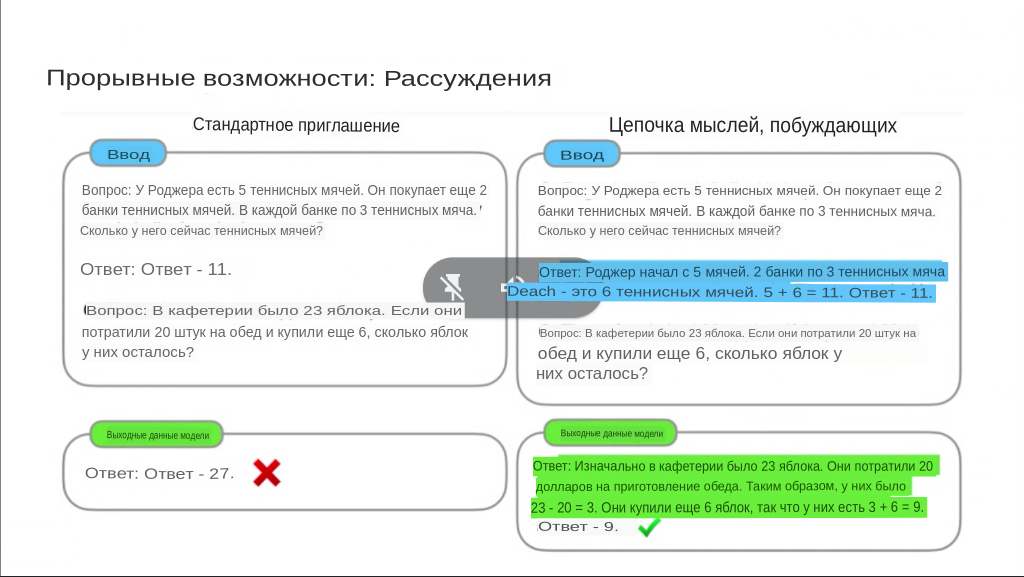

Метод, с помощью которого PaLM рассуждает, называется “подсказкой цепочки мыслей”. Шаран Наранг, один из инженеров, возглавляющих разработку PaLM, сказал мне, что большие языковые модели никогда не были хороши в логических переходах, если их специально не обучали этому. Дать большой языковой модели ответ на математическую задачу, а затем попросить ее воспроизвести способы решения этой математической задачи, как правило, не работает. Но в подсказке цепочки мыслей вы объясняете метод получения ответа вместо того, чтобы давать сам ответ. Этот подход ближе к обучению детей, чем к программированию машин. “Если бы вы просто сказали им, что ответ равен 11, они были бы сбиты с толку. Но если вы его сломаете, у них получится лучше ”, - сказал Наранг.

Google иллюстрирует процесс на следующем изображении:

К общей странности этого свойства добавляется тот факт, что сами инженеры Google не понимают, как и почему PaLM способен выполнять эту функцию. Разница между PaLM и другими моделями может заключаться в грубой вычислительной мощности. Возможно, дело в том, что только 78 процентов языка, на которых обучался PaLM, - английский, что расширяет возможности PaLM по сравнению с другими крупными языковыми моделями, такими как GPT-3. Или это может быть тот факт, что инженеры изменили способ обозначения математических данных во входных данных. У инженеров есть свои догадки, но они сами не чувствуют, что их догадки лучше, чем у кого-либо другого. Проще говоря, PaLM “продемонстрировал возможности, которых мы раньше не видели”, - сказал мне Ааканкша Чоудхери, соруководитель команды PaLM, который так же близок к пониманию PaLM, как и любой инженер.

Конечно, все это не имеет никакого отношения к искусственному сознанию. “Я не антропоморфизирую”, - прямо сказал Чоудхери. “Мы просто предсказываем язык”. Искусственное сознание - это далекая мечта, которая прочно укоренилась в научной фантастике, потому что мы понятия не имеем, что такое человеческое сознание; не существует функционирующего фальсифицируемого тезиса о сознании, просто набор расплывчатых понятий. И если нет способа проверить наличие сознания, нет способа его запрограммировать. Вы можете попросить алгоритм делать только то, что вы ему прикажете. Все, что мы можем придумать, чтобы сравнить машины с людьми, - это маленькие игры, такие как имитационная игра Тьюринга, которые в конечном итоге ничего не доказывают.

Вместо этого мы прибыли в место более чуждое, чем искусственное сознание. Как ни странно, такую программу, как PaLM, было бы легче понять, если бы она просто была разумной. Мы, по крайней мере, знаем, что влечет за собой переживание сознания. Все функции PaLM, которые я описал до сих пор, основаны не более чем на предсказании текста. Какое слово имеет смысл дальше? Вот и все. Вот и все. Почему эта функция привела к таким огромным скачкам в способности создавать смысл? Эта технология работает на субстратах, которые лежат в основе не только всего языка, но и всего смысла (или есть разница?), И эти субстраты в основе своей загадочны. PaLM может обладать модальностями, которые превосходят наше понимание. Что понимает PaLM, что мы не знаем, как спросить об этом?

Использование такого слова, как понимать, на данном этапе чревато. Одной из проблем в борьбе с реальностью НЛП является машина искусственного интеллекта, которая, как и все в Силиконовой долине, переоценивает себя. Google в своих рекламных материалах утверждает, что PaLM демонстрирует “впечатляющее понимание естественного языка”. Но что означает слово "понимание" в этом контексте? Я сам придерживаюсь двух мнений: с одной стороны, PaLM и другие большие языковые модели способны понимать в том смысле, что, если вы им что-то говорите, его значение регистрируется. С другой стороны, это совсем не похоже на человеческое понимание. “Я считаю, что наш язык не подходит для выражения таких вещей”, - сказал мне Зубин Гахрамани, вице-президент по исследованиям в Google. “У нас есть слова для отображения смысла между предложениями и объектами, и слова, которые мы используем, - это такие слова, как понимание. Проблема в том, что в узком смысле можно сказать, что эти системы понимают так же, как калькулятор понимает сложение, а в более глубоком смысле они не понимают. Мы должны отнестись к этим словам с недоверием ”. Излишне говорить, что разговоры в Twitter и вирусная информационная сеть в целом не особенно хороши в том, чтобы относиться к вещам с недоверием.

Гахрамани с энтузиазмом относится к тревожной неизвестности всего этого. Он работает в области искусственного интеллекта уже 30 лет, но сказал мне, что сейчас “самое захватывающее время для работы в этой области” именно из-за “скорости, с которой мы удивляемся технологиям”. Он видит огромный потенциал ИИ как инструмента в тех случаях, когда люди, откровенно говоря, очень плохо разбираются в вещах, но компьютеры и системы ИИ очень хороши в этом. “Мы склонны думать об интеллекте очень ориентированным на человека образом, и это приводит нас ко всевозможным проблемам”, - сказал Гахрамани. “Во-первых, мы очеловечиваем технологии, которые являются тупыми статистическими шаблонами. Другая проблема заключается в том, что мы стремимся имитировать человеческие способности, а не дополнять их ”. Например, люди не созданы для того, чтобы находить смысл в геномных последовательностях, но большие языковые модели могут быть. Большие языковые модели могут найти смысл там, где мы можем найти только хаос.

Несмотря на это, здесь присутствуют огромные социальные и политические опасности, а также все еще труднодостижимые возможности для красоты. Большие языковые модели не создают сознания, но они создают убедительные имитации сознания, которые только значительно улучшатся и будут продолжать сбивать людей с толку. Когда даже инженер Google не может отличить диалогового агента от реального человека, на что можно надеяться, когда эта информация дойдет до широкой публики? В отличие от машинного восприятия, эти вопросы реальны. Ответ на них потребует беспрецедентного сотрудничества между гуманистами и технологами. На карту поставлена сама природа смысла.

Итак, у Google нет искусственного сознания. Вместо этого он создает чрезвычайно мощные большие языковые системы с конечной целью, как сказал Наранг, “создать единую модель, которая может обобщать миллионы задач и обрабатывать данные по нескольким модальностям”. Честно говоря, этого достаточно, чтобы беспокоиться без научно-фантастических роботов, играющих на экранах в нашей голове. Google не планирует превращать PaLM в продукт. “Мы не должны забегать вперед с точки зрения возможностей”, - сказал Гахрамани. “Мы должны подходить ко всем этим технологиям осторожно и скептически”. Искусственный интеллект, особенно ИИ, полученный на основе глубокого обучения, имеет тенденцию к быстрому росту в периоды шокирующего развития, а затем останавливается. (См. раздел Самоуправляемые автомобили, медицинская визуализация и т.д.) Однако, когда происходят скачки, они происходят сильно, быстро и неожиданным образом. Гарамани сказал мне, что нам нужно безопасно достичь этих успехов. Он прав. Здесь мы говорим о машине с обобщенным значением: было бы неплохо быть осторожным.

Фантазия о разумности с помощью искусственного интеллекта не просто ошибочна; это скучно. Это мечта об инновациях на основе полученных идей, будущее для людей, чьи умы никогда не покидали чары научно-фантастических сериалов 1930-х годов. Вопросы, которые ставит перед нами новейшая технология искусственного интеллекта, являются самыми глубокими и самыми простыми; это вопросы, к которым мы, как всегда, совершенно не готовы. Я беспокоюсь, что у людей может просто не хватить интеллекта, чтобы справиться с последствиями искусственного интеллекта. Грань между нашим языком и языком машин размывается, и наша способность понимать разницу растворяется в размытости.

Машинное восприятие переоценено.

By Stephen Marche

19 ИЮНЯ 2022 ГОДА

Беттманн / Гетти

На прошлой неделе Google отправил одного из своих инженеров в административный отпуск после того, как он заявил, что столкнулся с машинным разумом в диалоге с агентом по имени ЛаМДА. Поскольку машинный разум является основным элементом фильмов, а мечта об искусственной личности стара, как сама наука, история стала вирусной, привлекая гораздо больше внимания, чем почти любая история об обработке естественного языка (NLP), которую когда-либо получали. Это позор. Представление о том, что LaMDA обладает разумом, является бессмыслицей: LaMDA не более сознателен, чем карманный калькулятор. Что еще более важно, глупой фантазии о машинном разуме снова позволили доминировать в разговорах об искусственном интеллекте, когда происходят гораздо более странные и богатые, потенциально опасные и красивые разработки.

Тот факт, что LaMDA, в частности, была в центре внимания, откровенно говоря, немного странный. ЛаМДА - диалоговый агент. Цель диалоговых агентов - убедить вас в том, что вы разговариваете с человеком. На данный момент совершенно убедительные чат-боты далеки от новаторских технологий. Такие программы, как Project December, уже способны воссоздавать умерших близких с помощью НЛП. Но эти симуляции не более живые, чем фотография вашего покойного прадеда.

Уже существуют модели, более мощные и загадочные, чем LaMDA. LaMDA оперирует до 137 миллиардами параметров, которые, говоря в широком смысле, представляют собой языковые шаблоны, которые НЛП на основе трансформатора использует для создания осмысленного текстового прогнозирования. Недавно я разговаривал с инженерами, работавшими над последней языковой моделью Google PaLM, которая имеет 540 миллиардов параметров и способна выполнять сотни отдельных задач без специального обучения для их выполнения. Это настоящий искусственный интеллект общего назначения, поскольку он может применяться к различным интеллектуальным задачам без специальной подготовки, так сказать, “из коробки”.

Некоторые из этих задач, очевидно, полезны и потенциально преобразуют. По словам инженеров — и, чтобы быть ясным, я сам не видел PaLM в действии, потому что это не продукт — если вы задаете ему вопрос на бенгальском, он может ответить как на бенгальском, так и на английском. Если вы попросите его перевести фрагмент кода с C на Python, он может это сделать. Он может обобщать текст. Он может объяснить шутки. Кроме того, есть функция, которая поразила ее собственных разработчиков и которая требует определенной дистанции и интеллектуальной хладнокровности, чтобы не волноваться. PaLM может рассуждать. Или, если быть более точным — и точность здесь очень важна — PaLM может действовать разумно.

Метод, с помощью которого PaLM рассуждает, называется “подсказкой цепочки мыслей”. Шаран Наранг, один из инженеров, возглавляющих разработку PaLM, сказал мне, что большие языковые модели никогда не были хороши в логических переходах, если их специально не обучали этому. Дать большой языковой модели ответ на математическую задачу, а затем попросить ее воспроизвести способы решения этой математической задачи, как правило, не работает. Но в подсказке цепочки мыслей вы объясняете метод получения ответа вместо того, чтобы давать сам ответ. Этот подход ближе к обучению детей, чем к программированию машин. “Если бы вы просто сказали им, что ответ равен 11, они были бы сбиты с толку. Но если вы его сломаете, у них получится лучше ”, - сказал Наранг.

Google иллюстрирует процесс на следующем изображении:

К общей странности этого свойства добавляется тот факт, что сами инженеры Google не понимают, как и почему PaLM способен выполнять эту функцию. Разница между PaLM и другими моделями может заключаться в грубой вычислительной мощности. Возможно, дело в том, что только 78 процентов языка, на которых обучался PaLM, - английский, что расширяет возможности PaLM по сравнению с другими крупными языковыми моделями, такими как GPT-3. Или это может быть тот факт, что инженеры изменили способ обозначения математических данных во входных данных. У инженеров есть свои догадки, но они сами не чувствуют, что их догадки лучше, чем у кого-либо другого. Проще говоря, PaLM “продемонстрировал возможности, которых мы раньше не видели”, - сказал мне Ааканкша Чоудхери, соруководитель команды PaLM, который так же близок к пониманию PaLM, как и любой инженер.

Конечно, все это не имеет никакого отношения к искусственному сознанию. “Я не антропоморфизирую”, - прямо сказал Чоудхери. “Мы просто предсказываем язык”. Искусственное сознание - это далекая мечта, которая прочно укоренилась в научной фантастике, потому что мы понятия не имеем, что такое человеческое сознание; не существует функционирующего фальсифицируемого тезиса о сознании, просто набор расплывчатых понятий. И если нет способа проверить наличие сознания, нет способа его запрограммировать. Вы можете попросить алгоритм делать только то, что вы ему прикажете. Все, что мы можем придумать, чтобы сравнить машины с людьми, - это маленькие игры, такие как имитационная игра Тьюринга, которые в конечном итоге ничего не доказывают.

Вместо этого мы прибыли в место более чуждое, чем искусственное сознание. Как ни странно, такую программу, как PaLM, было бы легче понять, если бы она просто была разумной. Мы, по крайней мере, знаем, что влечет за собой переживание сознания. Все функции PaLM, которые я описал до сих пор, основаны не более чем на предсказании текста. Какое слово имеет смысл дальше? Вот и все. Вот и все. Почему эта функция привела к таким огромным скачкам в способности создавать смысл? Эта технология работает на субстратах, которые лежат в основе не только всего языка, но и всего смысла (или есть разница?), И эти субстраты в основе своей загадочны. PaLM может обладать модальностями, которые превосходят наше понимание. Что понимает PaLM, что мы не знаем, как спросить об этом?

Использование такого слова, как понимать, на данном этапе чревато. Одной из проблем в борьбе с реальностью НЛП является машина искусственного интеллекта, которая, как и все в Силиконовой долине, переоценивает себя. Google в своих рекламных материалах утверждает, что PaLM демонстрирует “впечатляющее понимание естественного языка”. Но что означает слово "понимание" в этом контексте? Я сам придерживаюсь двух мнений: с одной стороны, PaLM и другие большие языковые модели способны понимать в том смысле, что, если вы им что-то говорите, его значение регистрируется. С другой стороны, это совсем не похоже на человеческое понимание. “Я считаю, что наш язык не подходит для выражения таких вещей”, - сказал мне Зубин Гахрамани, вице-президент по исследованиям в Google. “У нас есть слова для отображения смысла между предложениями и объектами, и слова, которые мы используем, - это такие слова, как понимание. Проблема в том, что в узком смысле можно сказать, что эти системы понимают так же, как калькулятор понимает сложение, а в более глубоком смысле они не понимают. Мы должны отнестись к этим словам с недоверием ”. Излишне говорить, что разговоры в Twitter и вирусная информационная сеть в целом не особенно хороши в том, чтобы относиться к вещам с недоверием.

Гахрамани с энтузиазмом относится к тревожной неизвестности всего этого. Он работает в области искусственного интеллекта уже 30 лет, но сказал мне, что сейчас “самое захватывающее время для работы в этой области” именно из-за “скорости, с которой мы удивляемся технологиям”. Он видит огромный потенциал ИИ как инструмента в тех случаях, когда люди, откровенно говоря, очень плохо разбираются в вещах, но компьютеры и системы ИИ очень хороши в этом. “Мы склонны думать об интеллекте очень ориентированным на человека образом, и это приводит нас ко всевозможным проблемам”, - сказал Гахрамани. “Во-первых, мы очеловечиваем технологии, которые являются тупыми статистическими шаблонами. Другая проблема заключается в том, что мы стремимся имитировать человеческие способности, а не дополнять их ”. Например, люди не созданы для того, чтобы находить смысл в геномных последовательностях, но большие языковые модели могут быть. Большие языковые модели могут найти смысл там, где мы можем найти только хаос.

Несмотря на это, здесь присутствуют огромные социальные и политические опасности, а также все еще труднодостижимые возможности для красоты. Большие языковые модели не создают сознания, но они создают убедительные имитации сознания, которые только значительно улучшатся и будут продолжать сбивать людей с толку. Когда даже инженер Google не может отличить диалогового агента от реального человека, на что можно надеяться, когда эта информация дойдет до широкой публики? В отличие от машинного восприятия, эти вопросы реальны. Ответ на них потребует беспрецедентного сотрудничества между гуманистами и технологами. На карту поставлена сама природа смысла.

Итак, у Google нет искусственного сознания. Вместо этого он создает чрезвычайно мощные большие языковые системы с конечной целью, как сказал Наранг, “создать единую модель, которая может обобщать миллионы задач и обрабатывать данные по нескольким модальностям”. Честно говоря, этого достаточно, чтобы беспокоиться без научно-фантастических роботов, играющих на экранах в нашей голове. Google не планирует превращать PaLM в продукт. “Мы не должны забегать вперед с точки зрения возможностей”, - сказал Гахрамани. “Мы должны подходить ко всем этим технологиям осторожно и скептически”. Искусственный интеллект, особенно ИИ, полученный на основе глубокого обучения, имеет тенденцию к быстрому росту в периоды шокирующего развития, а затем останавливается. (См. раздел Самоуправляемые автомобили, медицинская визуализация и т.д.) Однако, когда происходят скачки, они происходят сильно, быстро и неожиданным образом. Гарамани сказал мне, что нам нужно безопасно достичь этих успехов. Он прав. Здесь мы говорим о машине с обобщенным значением: было бы неплохо быть осторожным.

Фантазия о разумности с помощью искусственного интеллекта не просто ошибочна; это скучно. Это мечта об инновациях на основе полученных идей, будущее для людей, чьи умы никогда не покидали чары научно-фантастических сериалов 1930-х годов. Вопросы, которые ставит перед нами новейшая технология искусственного интеллекта, являются самыми глубокими и самыми простыми; это вопросы, к которым мы, как всегда, совершенно не готовы. Я беспокоюсь, что у людей может просто не хватить интеллекта, чтобы справиться с последствиями искусственного интеллекта. Грань между нашим языком и языком машин размывается, и наша способность понимать разницу растворяется в размытости.

ОТВЕТЫ (0)

Комментарии не найдены!