IT в России и мире в реалиях мирового кризиса

1,415,514

8,485

Москва

62 года

Карма: +212.81

Регистрация: 15.07.2009

Сообщений: 31,550

Читатели: 8

Регистрация: 15.07.2009

Сообщений: 31,550

Читатели: 8

Цитата: adolfus от 08.11.2020 02:13:29Nvidia не занимается нейросетями и ничего для их моделирования специально не выпускает. Nvidia занимается высокопроизводительными вычислениями, рендерингом графики и чипсетами для материнок. И причем Nvidia GPU к IVA TPU не совсем понятно. Это как сравнение безногого с хромым – второй в любом случае потеснит первого на соревнованиях по ходьбе.

Вы б хоть пару строк прочитали про архитектуру Нвидии, прежде чем писать сюда такую чушь.

Значительная часть кристалла у них — тензорные процессоры, которые и реализованы в обсуждаемом устройстве.

Многие пытаются смотреть, куда идёт дым.

А надо бы - откуда ветер дует.

А надо бы - откуда ветер дует.

Архангельск

50 лет

Карма: +10.29

Регистрация: 27.10.2008

Сообщений: 4,257

Читатели: 1

Регистрация: 27.10.2008

Сообщений: 4,257

Читатели: 1

Цитата: slavae от 05.11.2020 19:13:53Да херня этот мем. Я покупал штук 10 телефонов с али, всё всегда было нормально.

как я скучно живу....

Сейчас задумался, посчитал... Оказалось, что я за всю свою никчемную жисть купил (включая аппараты двум детям, жене, себе любимому и родителей) всего 9 телефонов... И это при том, что к чуду мобильной связи присосался еще в 1999 годЕ....

ЗЫ. Справедливости ради - дети сейчас выросли, разбежались и уже по N аппаратов поменяли - но это уже их собственные тараканы...

Малороссия

Карма: +14.59

Регистрация: 28.06.2014

Сообщений: 26,564

Читатели: 9

Регистрация: 28.06.2014

Сообщений: 26,564

Читатели: 9

Цитата: Aристарх от 09.11.2020 19:27:56Вот аналогично. С 2000 года было 4 телефона, все кнопочные, все рабочие (только аккумуляторы у них умирают). Пятый в январе подарили жена с дочкой на ДР, сказали, что я задолбал своим консерватизмом, вручили и велели осваивать смартфон (со всеми этими Вацапами-Виберами-Телеграммами). Из наиболее полезного - Яндекс-Навигатор туда поставил, город-то неплохо знаю, а в пригородах могу и заплутать.И фото-видео теперь частенько пользуюсь.

У аккуратных пряморуких людей вещи десятилетиями могут служить.

А жене и дочке только успеваю экраны менять (по Ютубу научился). Вот когда утопляют тут уж все, по паре штук в год уничтожают и новые покупают, не из-за моды. (

У меня три телефона с 02 года.

И планшет

Карма: +17.16

Регистрация: 05.01.2014

Сообщений: 1,492

Читатели: 1

Регистрация: 05.01.2014

Сообщений: 1,492

Читатели: 1

Цитата: Aристарх от 09.11.2020 19:27:56Вот когда утопляют тут уж все, по паре штук в год уничтожают и новые покупают, не из-за моды. (

Ладно бы только "утопляют". Иногда такое может и прокатит. Но они же, сразу после "спасения", его под струю воды мыть суют

Москва

Карма: +193.52

Регистрация: 21.03.2013

Сообщений: 28,041

Читатели: 7

Регистрация: 21.03.2013

Сообщений: 28,041

Читатели: 7

Цитата: Cheen от 09.11.2020 21:15:23У меня три телефона с 02 года.

И планшет

Если уж вспоминать, то первый «смартфон» я купил на али в 11 году для племянницы. Это был 4.3 аппарат на андроиде 2.3, звался HD7. Стоил 190 ненаших.

http://kitmobi.ru/articles/reviews/93-htc-hd7-3g-hero-h7300.html

Супервещь, позволила нам понять что это, нужно ли это. А не изображать из себя дедов с кнопками )

Отредактировано: slavae - 09 ноя 2020 23:25:16

Империя - это мир, и этой идеологии достаточно. Мы живём в самой лучшей стране в мире и все нам завидуют.

Одушевлённое Одевают, Неодушевлённое Надевают.

Одушевлённое Одевают, Неодушевлённое Надевают.

64 года

Карма: +7.54

Регистрация: 20.10.2008

Сообщений: 4,398

Читатели: 1

Регистрация: 20.10.2008

Сообщений: 4,398

Читатели: 1

Цитата: Aристарх от 09.11.2020 19:27:56А жене и дочке только успеваю экраны менять (по Ютубу научился). Вот когда утопляют тут уж все, по паре штук в год уничтожают и новые покупают, не из-за моды. (

Иногда помогает, если (вытащив батарею) засунуть телефон в спирт, чтобы вытеснить воду. Потом просушить.

Карма: +19.18

Регистрация: 12.02.2010

Сообщений: 12,149

Читатели: 3

Регистрация: 12.02.2010

Сообщений: 12,149

Читатели: 3

Цитата: dmitriк62 от 09.11.2020 11:01:27Вы б хоть пару строк прочитали про архитектуру Нвидии, прежде чем писать сюда такую чушь.

Значительная часть кристалла у них — тензорные процессоры, которые и реализованы в обсуждаемом устройстве.

У них – это у кого? У нвидии? Модель GPU назовите, у которой значительная часть кристалла "тензорные" процессоры. Я больше имею дело с вычислениями на их гпу через куду и другими их железками не интересуюсь.

И, кстати, что это за процессоры такие, "тензорные"? Стово "тензорный" в приложении к нейросетям означает обыкновенную двумерную свертку, возраст которой в быстром варианте семьдесят с лишним лет (ЕМНИП, в 1946 году опубликовали первую статью про двумерное БПФ, лежащее в ее основе).

Отредактировано: adolfus - 10 ноя 2020 01:28:59

Южная Сибирь

Карма: +2.68

Регистрация: 09.02.2010

Сообщений: 613

Читатели: 0

Регистрация: 09.02.2010

Сообщений: 613

Читатели: 0

Цитата: Longspig от 09.11.2020 23:11:00Ладно бы только "утопляют". Иногда такое может и прокатит. Но они же, сразу после "спасения", его под струю воды мыть суют

Хм, у меня противоударный. Сэкономил уже тысяч сто, ибо практикую велотуризм. А еще я его регулярно с мылом мою. Ибо грязный телефон -- это не гигиенично. Особенно в современных условиях. Лопата.

Томск

53 года

Карма: +0.25

Регистрация: 14.02.2009

Сообщений: 1,178

Читатели: 0

Регистрация: 14.02.2009

Сообщений: 1,178

Читатели: 0

Цитата: vaa от 09.11.2020 18:19:33как я скучно живу....

Сейчас задумался, посчитал... Оказалось, что я за всю свою никчемную жисть купил (включая аппараты двум детям, жене, себе любимому и родителей) всего 9 телефонов... И это при том, что к чуду мобильной связи присосался еще в 1999 годЕ....

ЗЫ. Справедливости ради - дети сейчас выросли, разбежались и уже по N аппаратов поменяли - но это уже их собственные тараканы...

А я живу весело!!!

Я себе ни одного аппарата не покупал, хотя тоже где-то с 99-го на связи. Мне сначала дарили штуки 3-4, два из них украдены, остальные где-то валяются. А теперь взял моду за сыном донашивать. Один за женой донашивал, уронил на кафельный пол со второго этажа, стало неудобно пользоваться

.

.

Южный Урал

Карма: +0.58

Регистрация: 16.01.2009

Сообщений: 3,786

Читатели: 0

Регистрация: 16.01.2009

Сообщений: 3,786

Читатели: 0

Цитата: Reader. от 10.11.2020 08:52:53Сотовые - это очень весело!

Да ладно Вам, это же ностальгия!

У меня тоже за 20 лет только три телефона было

Но вот первый никогда не забуду, в 99 году все девки были твоими как только видели сотик на поясе

Москва

62 года

Карма: +212.81

Регистрация: 15.07.2009

Сообщений: 31,550

Читатели: 8

Регистрация: 15.07.2009

Сообщений: 31,550

Читатели: 8

Цитата: adolfus от 10.11.2020 01:03:56У них – это у кого? У нвидии? Модель GPU назовите, у которой значительная часть кристалла "тензорные" процессоры. Я больше имею дело с вычислениями на их гпу через куду и другими их железками не интересуюсь.

И, кстати, что это за процессоры такие, "тензорные"? Стово "тензорный" в приложении к нейросетям означает обыкновенную двумерную свертку, возраст которой в быстром варианте семьдесят с лишним лет (ЕМНИП, в 1946 году опубликовали первую статью про двумерное БПФ, лежащее в ее основе).

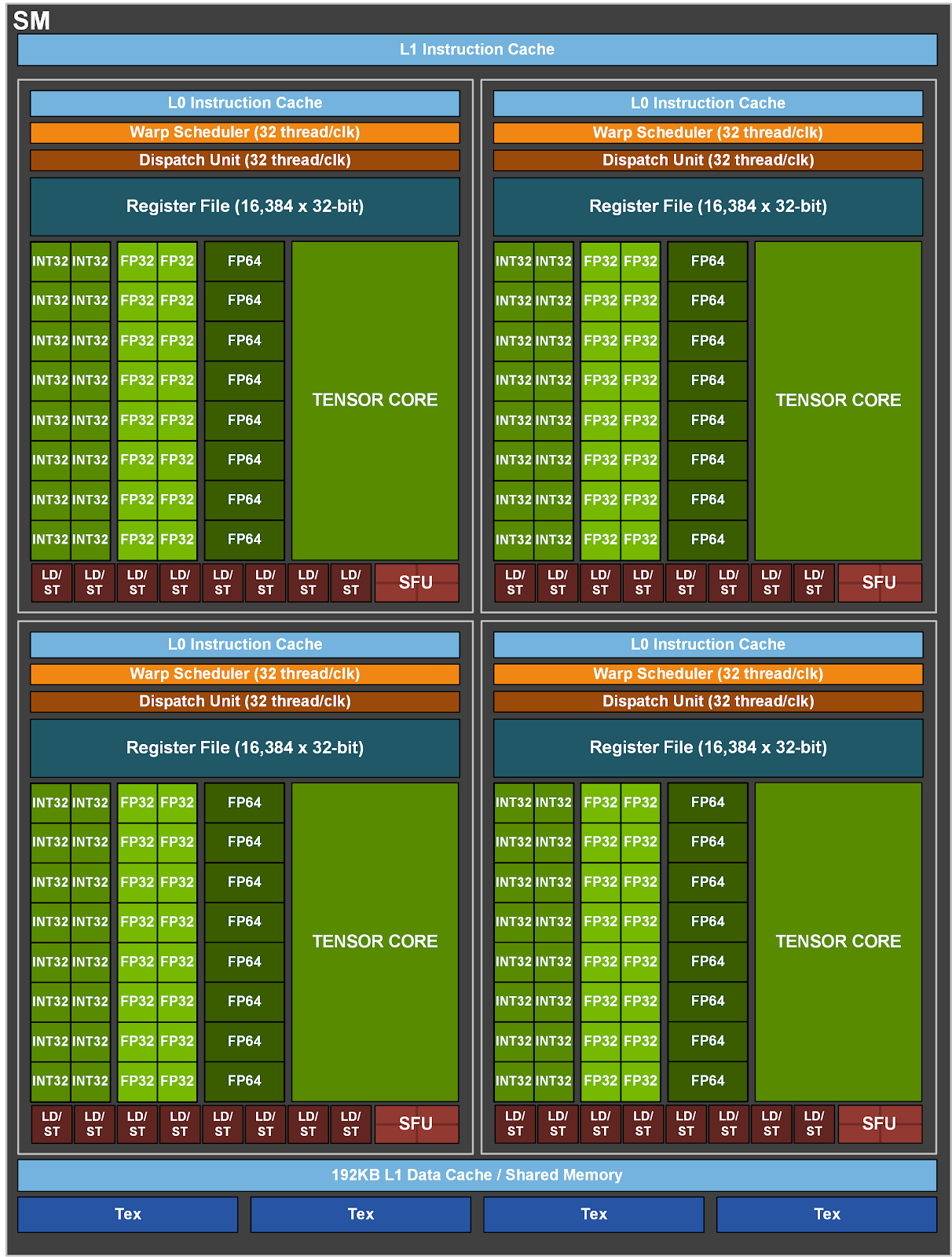

Ну вот современный кристалл GA100:

Есть огромная масса приложений, которая использует только эту часть, CUDA там нужна только для загрузки тензорных регистров.

Остальное на чипе у Ненавидии просто простаивает на этих задачах.

И вот наши ребята для таких модных приложений сделали вдвое более эффективную архитектуру без всех остальной требухи вроде видеодекодера, текстуринга, трассировки лучей, всяких int/float/double вычислителей и т.д.

Так что им можно только рукоплескать...

Отредактировано: dmitriк62 - 10 ноя 2020 10:54:06

Многие пытаются смотреть, куда идёт дым.

А надо бы - откуда ветер дует.

А надо бы - откуда ветер дует.

Карма: +19.18

Регистрация: 12.02.2010

Сообщений: 12,149

Читатели: 3

Регистрация: 12.02.2010

Сообщений: 12,149

Читатели: 3

Цитата: dmitriк62 от 10.11.2020 10:40:12Ну вот современный кристалл GA100:

Скрытый текст

Есть огромная масса приложений, которая использует только эту часть, CUDA там нужна только для загрузки тензорных регистров.

Остальное на чипе у Ненавидии просто простаивает на этих задачах.

И вот наши ребята для таких модных приложений сделали вдвое более эффективную архитектуру без всех остальной требухи вроде видеодекодера, текстуринга, трассировки лучей, всяких int/float/double вычислителей и т.д.

Так что им можно только рукоплескать...

Эти "тензорные" ядра никакого отношения к AI не имеют – это просто ускорители операции свертки c^i_j = a^i_k b^k_j. То, что их используют в

Отредактировано: adolfus - 10 ноя 2020 12:08:54

Москва

62 года

Карма: +212.81

Регистрация: 15.07.2009

Сообщений: 31,550

Читатели: 8

Регистрация: 15.07.2009

Сообщений: 31,550

Читатели: 8

Цитата: adolfus от 10.11.2020 12:06:43Эти "тензорные" ядра никакого отношения к AI не имеют – это просто ускорители операции свертки c^i_j = a^i_k b^k_j. То, что их используют вобучениитренировке нейросетей, ничего к этим ядрам не добавляет – эти ядра предназначены для выполнения матричных операций, в частности, для перемножения матриц, что есть свертка в чистом виде. И то, что AIлы внезапно обнаружили это, не делает их сугубо AIными. К AI эти ядра имеют такое же отношение, как кислое к щам.

Вы пишете о вещах, о которых не имеете ни малейшего представления.

Многие пытаются смотреть, куда идёт дым.

А надо бы - откуда ветер дует.

А надо бы - откуда ветер дует.

Карма: +19.18

Регистрация: 12.02.2010

Сообщений: 12,149

Читатели: 3

Регистрация: 12.02.2010

Сообщений: 12,149

Читатели: 3

Цитата: dmitriк62 от 10.11.2020 12:40:03Вы пишете о вещах, о которых не имеете ни малейшего представления.

Не надо столь аппеляционно... Вот читата из документации на кишки того самого GA100, что Вы упомянули (стр. 22)

ЦитатаThird-Generation NVIDIA Tensor Core

Tensor Cores are specialized high-performance compute cores for matrix math operations that

provide groundbreaking performance for AI and HPC applications. Tensor Cores perform matrix

multiply and accumulate (MMA) calculations...

-- Пщщпду екфтыдфеу --

Тензорные ядра – это специализированные высокопроизводительные вычислительные ядра для матричных математических операций, которые обеспечивают революционную производительность для приложений AI и HPC. Тензорные ядра выполняют вычисления матричного умножения с накоплением (MMA)...

Этот самый "matrix multiply" и есть свертка в ее чистейшем виде. Запишу еще раз эту операцию лично для Вас в тензорной нотации:

c^i_j = a^i_k b^k_j

На всякий случай, если Вы "не имеете ни малейшего представления" о LaTeX, картинку даю

На всякий случай, если Вы "не имеете ни малейшего представления" о тензорной нотации, даю картинку в матричной форме в компонентах

Там, правда, про MMA, но даже коза знает, что MMA = MM + A. (в чисто матричной форме)

На следующей странице того же мануала вышеизложенное развивается и детализируется для школоло

ЦитатаGeneral Matrix-Matrix Multiplication (GEMM) operations are at the core of neural network

training and inference, and are used to multiply large matrices of input data and weights in

various layers. The GEMM operation computes the matrix product D = A * B + C, where C and

D are m-by-n matrices, A is an m-by-k matrix, and B is a k-by-n matrix. The problem size of

such GEMM operations running on Tensor Cores is defined by the matrix sizes, and typically

denoted as m-by-n-by-k.

даже переводить не буду...

Отредактировано: adolfus - 10 ноя 2020 20:46:07

Москва

62 года

Карма: +212.81

Регистрация: 15.07.2009

Сообщений: 31,550

Читатели: 8

Регистрация: 15.07.2009

Сообщений: 31,550

Читатели: 8

Цитата: adolfus от 10.11.2020 20:23:27Не надо столь аппеляционно... Вот читата из документации на кишки того самого GA100, что Вы упомянули (стр. 22)

Этот самый "matrix multiply" и есть свертка в ее чистейшем виде. Запишу еще раз эту операцию лично для Вас в тензорной нотации:

c^i_j = a^i_k b^k_j

На всякий случай, если Вы "не имеете ни малейшего представления" о LaTeX, картинку даю

На всякий случай, если Вы "не имеете ни малейшего представления" о тензорной нотации, даю картинку в матричной форме в компонентах

Там, правда, про MMA, но даже коза знает, что MMA = MM + A. (в чисто матричной форме)

На следующей странице того же мануала вышеизложенное развивается и детализируется для школоло

даже переводить не буду...

Послушайте, господин любитель оскорбить.

Я Вам не школоло.

А вот Вы, копирующий детсадовскую элементарщину из учебника (видимо, и сам не особо её понимая) — типичный трололо.

Вы хоть посмотрели бы, с какими типами данных работает вся эта сноповязалка, тогда, может быть, и задумались бы, для чего всё это сделано...

Многие пытаются смотреть, куда идёт дым.

А надо бы - откуда ветер дует.

А надо бы - откуда ветер дует.

Алма-Ата

60 лет

Карма: +0.18

Регистрация: 20.01.2020

Сообщений: 215

Читатели: 0

Регистрация: 20.01.2020

Сообщений: 215

Читатели: 0

Об NVDIA

Господа-товарищи-коллеги , а не проще было у nvidia спросить, делается там что-то или нет в обсуждаемом вами направлении. Извините, просто удивило, что никто не сходил к ним на сайт ну или не дал ссылок.

https://www.nvidia.c…xavier-nx/

https://www.nvidia.c…/learn-ai/

https://www.nvidia.c…-platform/

Господа-товарищи-коллеги , а не проще было у nvidia спросить, делается там что-то или нет в обсуждаемом вами направлении. Извините, просто удивило, что никто не сходил к ним на сайт ну или не дал ссылок.

https://www.nvidia.c…xavier-nx/

https://www.nvidia.c…/learn-ai/

https://www.nvidia.c…-platform/

Отредактировано: Вариант - 11 ноя 2020 11:22:56

Карма: +19.18

Регистрация: 12.02.2010

Сообщений: 12,149

Читатели: 3

Регистрация: 12.02.2010

Сообщений: 12,149

Читатели: 3

Цитата: Вариант от 11.11.2020 11:05:28Об NVDIA

Господа-товарищи-коллеги , а не проще было у nvidia спросить, делается там что-то или нет в обсуждаемом вами направлении. Извините, просто удивило, что никто не сходил к ним на сайт ну или не дал ссылок.

https://www.nvidia.c…xavier-nx/

https://www.nvidia.c…/learn-ai/

https://www.nvidia.c…-platform/

Я выше дал ссылку на документацию, где черным по белому написано, что эти "тензорные" процессоры вычисляют свертку с накоплением.

Карма: +19.18

Регистрация: 12.02.2010

Сообщений: 12,149

Читатели: 3

Регистрация: 12.02.2010

Сообщений: 12,149

Читатели: 3

Цитата: dmitriк62 от 11.11.2020 09:55:26Послушайте, господин любитель оскорбить.

Я Вам не школоло.

А вот Вы, копирующий детсадовскую элементарщину из учебника (видимо, и сам не особо её понимая) — типичный трололо.

Официальная документация nvidia – это "детсадовская элементарщина из учебника"?

Цитата: dmitriк62 от 11.11.2020 09:55:26Вы хоть посмотрели бы, с какими типами данных работает вся эта сноповязалка, тогда, может быть, и задумались бы, для чего всё это сделано...

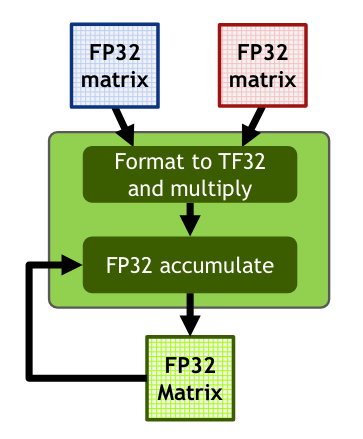

Сделано, чтобы матрицы с типом элемента FP32 перемножать с накоплением и без. Вот скриншот из https://developer.nvidia.com/blog/programming-tensor-cores-cuda-9/, где четко написано – "свертки и матричные операции" (convolutions & matrix ops.).

Специальный тип данных TF32 (для АИ) существует где-то на уровне микроинструкции умножения в контексте инструкции MMA и нигде не появляется вне блока MMA. Блок MMA получает на входе пару матриц FP32 и отдает на выходе матрицу FP32. У GA100 нет (см. формат регистровых полей ядра) места для хранения TF32 – в процессе ввода FP32 на векторные умножители мантисса у FP32 (IEEE 754 32 bit) обрезается до 10-и бит перед самим матричным умножением. результат умножения имеет формат FP32.

В мануалах и в статьях на сайте nvidia даже картинка есть на сей счет (Fig 9. на стр. 27). TF32 появляется в глубине MMA, там же и исчезает.

Москва

62 года

Карма: +212.81

Регистрация: 15.07.2009

Сообщений: 31,550

Читатели: 8

Регистрация: 15.07.2009

Сообщений: 31,550

Читатели: 8

Цитата: adolfus от 11.11.2020 20:20:36Я выше дал ссылку на документацию, где черным по белому написано, что эти "тензорные" процессоры вычисляют свертку с накоплением.

В отличие от Вас, я эту документацию давно зачитал до дыр.

Нвидия (в отличие от придурков типа Интеля) при развитии архитектур постоянно работает напрямую с пользователями.

И абстрактные вещи никогда не внедряет.

Так вот, задумайтесь, кому нужна свёртка с такими типами данных (вроде int4, например)?

При отсутствии поддержки даже float32.

Такое нужно только для одного из специфических подходов к ИИ, больше нигде.

И они — мировой лидер в этой области сейчас.

Возвращаясь к началу дискуссии — наши ребята сделали такой спецпроцессор без ненужной требухи, да ещё и в два раза более эффективный.

Многие пытаются смотреть, куда идёт дым.

А надо бы - откуда ветер дует.

А надо бы - откуда ветер дует.

Карма: +19.18

Регистрация: 12.02.2010

Сообщений: 12,149

Читатели: 3

Регистрация: 12.02.2010

Сообщений: 12,149

Читатели: 3

Цитата: dmitriк62 от 12.11.2020 11:00:32В отличие от Вас, я эту документацию давно зачитал до дыр.

Нвидия (в отличие от придурков типа Интеля) при развитии архитектур постоянно работает напрямую с пользователями.

И абстрактные вещи никогда не внедряет.

Так вот, задумайтесь, кому нужна свёртка с такими типами данных (вроде int4, например)?

При отсутствии поддержки даже float32.

Такое нужно только для одного из специфических подходов к ИИ, больше нигде.

И они — мировой лидер в этой области сейчас.

Возвращаясь к началу дискуссии — наши ребята сделали такой спецпроцессор без ненужной требухи, да ещё и в два раза более эффективный.

Свертка нужна много где, и в первую очередь в HPC. А вот нейросети как "выскочили прыщом", так скоро и "засохнут". Как только с них состригут хайповые пенки, так и все. Просто вспомним, что перед нейросетями nvidia бешено стригла c "криптошахтеров". Где сегодня та крипта? Сегодня они суетятся с AI.

Что касается того, как nvidia работает с пользователями, мы это видим на НСКФ, где ее представители и представители AMD выступают на пленарных заседаниях.

А что касается российского спецпроцессора для MAA, будем надеяться, что разрядность мантиссы у него таки правильная, как указано в IEEE 754. Тогда это позволит ему держаться какое-то время на рынке. Кстати, эти самые "тензорные ядра" были во всех суперкомпьютерах конца 70-х – они составляли их архитектурный базис.

Отредактировано: adolfus - 12 ноя 2020 12:40:19

Сейчас на ветке:

6,

Модераторов: 0,

Пользователей: 0,

Гостей: 1,

Ботов: 5